Вероятностный подход к измерению дискретной и непрерывной информации

В основе теории информации лежит предложенный Шенноном способ измерения количества информации, содержащейся в одной сл.в. относительно другой сл. в. Этот способ приводит к выражению количества информации числом.

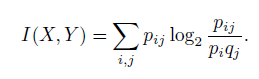

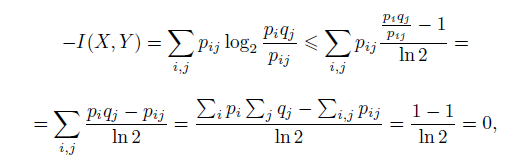

Для д.с.в. X и Y , заданных законами распределения P(X = Xi) = pi, P(Y = Yj) = qj и совместным распределением P(X = Xi, Y = Yj) = pij , количество информации, содержащейся в X относительно Y , равно

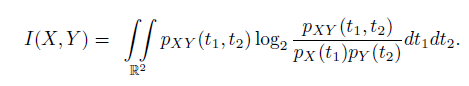

Для непрерывных сл. в. X и Y , заданных плотностями распределения вероятностей pX(t1), pY (t2) и pXY (t1, t2), аналогичная формула имеет вид

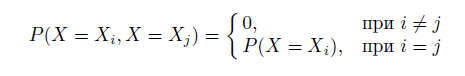

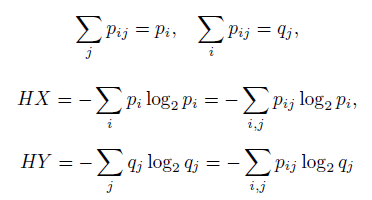

Очевидно, что

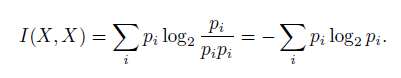

и, следовательно,

Энтропия д.с.в. X в теории информации определяется формулой

H(X) = HX = I(X,X).

Свойства меры информации и энтропии:

1) I(X, Y ) > 0, I(X, Y ) = 0 ↔ X и Y независимы;

2) I(X, Y ) = I(Y,X);

3) HX = 0 ↔ X — константа;

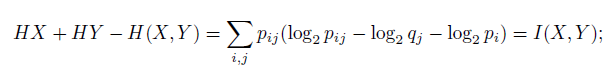

4) I(X, Y ) = HX + HY − H(X, Y ), где H(X, Y ) = ![]()

5) I(X, Y ) 6 I(X,X). Если I(X, Y ) = I(X,X), то X — функция от Y .

1) Логарифмированием из очевидного для всех x неравенства ex−1 > x (равенство устанавливается только при x = 1) получается неравенство x−1 ≥ ln x или (x−1)/ln 2 ≥ log2x.

т.е. I(X, Y ) = 0 только при pij = piqj для всех i и j, т.е. при независимости X и Y . Если X и Y независимы, то pij = piqj и, следовательно, аргументы логарифмов равны 1 и, следовательно, сами логарифмы равны 0, что означает, что I(X, Y ) = 0;

2) Следует из симметричности формул относительно аргументов;

3) Если HX = 0, то все члены суммы, определяющей HX, должны быть нули, что возможно тогда и только тогда, когда X — константа;

4) Из четырех очевидных соотношений

получается

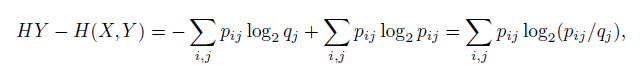

5) Нужно доказать I(X, Y ) = HX + HY − H(X, Y ) ≤ HX или HY − H(X, Y ) ≤ 0.

но pij = P(X = Xi, Y = Yj) ≤ qj = P(Y = Yj), а значит аргументы у всех логарифмов не больше 1 и, следовательно, значения логарифмов не больше 0, а это и значит, что вся сумма не больше 0.

Если HX = I(X, X) = I(X, Y ), то для каждого i pij равно либо qj , либо 0. Но из pij = P(X = Xi, Y = Yj) = P(X = Xi/Y = Yj)P(Y = Yj) ∈ {qj , 0} следует P(X = Xi/Y = Yj) ∈ {0, 1}, что возможно только в случае,

когда X — функция от Y .

При независимости сл. в. X и Y одна из них ничем не описывает другую, что и отражается в том, что для таких сл.в. I(X, Y ) = 0.

Рассмотрим пример измерения количества информации при подбрасывании двух игральных костей.

Пусть заданы д. с. в. X1, X2 и Y . X1 и X2 — количества очков, выпавших соответственно на 1-й и 2-й игральной кости, а Y = X1 + X2.

Найти I(Y, X1), I(X1, X1), I(Y, Y ).

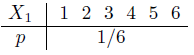

Законы распределения вероятностей для д.с.в. X1 и X2 совпадают, т.к. кости одинаковые и без изъянов. , т.е. при j = 1...6 qj = P(X1 = j) = 1/6.

, т.е. при j = 1...6 qj = P(X1 = j) = 1/6.

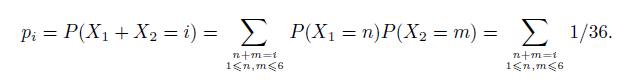

Закон распределения вероятностей для д.с.в. Y,

P(Y = i) = P(X1 + X2 = i), i = 2...12,

вследствие того, что X1, X2 — независимы и поэтому P(X1 = n, X2 = m) = P(X1 = n) P(X2 = m),

будет

Таблицы, определяющие Y:

т.е. при i = 2...12, pi = P(Y = i) = (6 − |7 − i|)/36.

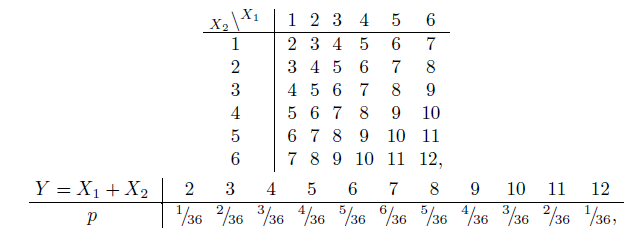

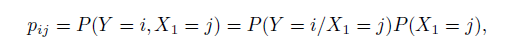

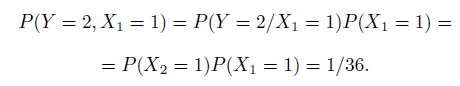

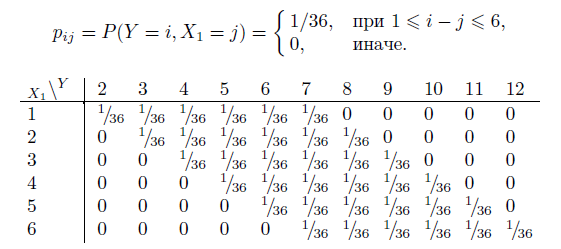

Закон совместного распределения вероятностей д.с.в. X1 и Y будет

например,

В общем случае получится

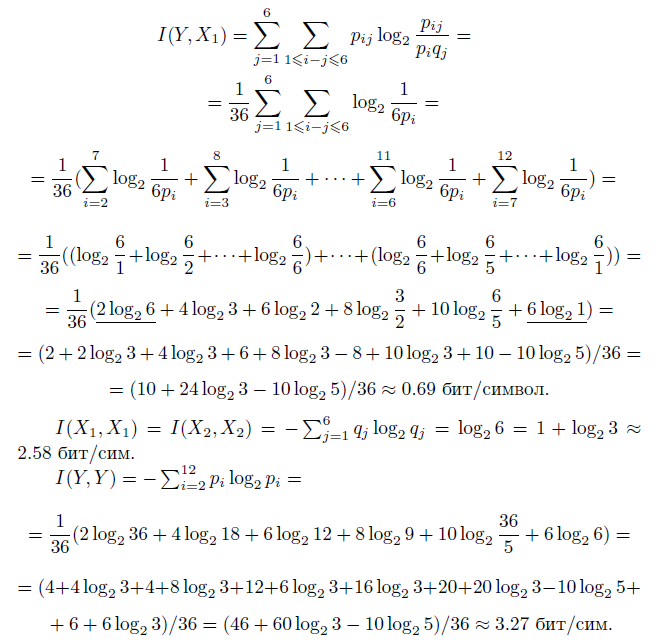

Тогда

Здесь 0 < I(Y, X1) = I(Y, X2) < I(X1, X1) = I(X2, X2) < I(Y, Y ), что соответствует свойствам информации.

Подчеркнутый член 1/36 2log26 = I(X1, X1)/18 в расчете I(X1, Y ) соответствует информации о двух случаях из 36, когда Y = 2 и Y = 12, которые однозначно определяют X1. Шесть случаев, когда Y = 7, не несут никакой информации об X1, что соответствует подчеркнутому члену 6log21 = 0.

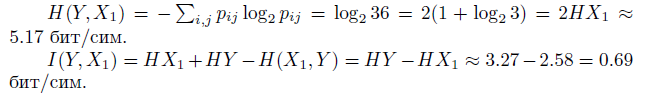

Расчеты можно проводить, используя 4-е свойство информации, через энтропию.

Расчет количества информации с использованием 4-го свойства, а не определения, обычно требует меньше вычислений.

Рассмотрим более простой пример. Пусть д. с.в. X равна количеству очков, выпавших на игральной кости, а д. с. в. Y равна 0, если выпавшее количество очков нечетно, и 1, если выпавшее количество очков четно. Найти I(X, Y ) и I(Y, Y ).

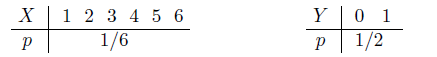

Составим законы распределения вероятностей д.с.в. X и Y .

Таким образом, при i = 1...6 pi = P(X = i) = 1/6 и, соответственно, при j = 0...1 qj = P(Y = j) = 1/2.

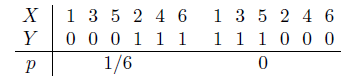

Составим также закон совместного распределения вероятностей этих д.с.в.

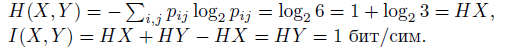

Точное количество выпавших очков дает точную информацию о четности, т.е. 1 бит. Из I(X, Y ) = I(Y, Y ) = 1 бит/сим и 3-го свойства информации следует, что информация об X полностью определяет Y , но не наоборот, т.к. I(X, Y ) ≠ I(X, X) = 1+log23 ≈ 2.58 бит/сим. Действительно, Y функционально зависит от X, а X от Y функционально не зависит.

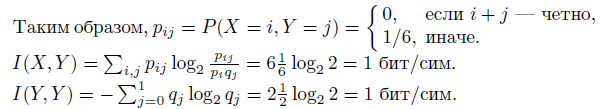

Расчеты через энтропию будут следующими

Смысл энтропии Шеннона

Энтропия д.с.в. — это минимум среднего количества бит, которое нужно передавать по каналу связи о текущем значении данной д.с.в.

Рассмотрим пример (скачки). В заезде участвуют 4 лошади с равными шансами на победу, т.е. вероятность победы каждой лошади равна 1/4. Введем д. с. в. X, равную номеру победившей лошади. Здесь HX = 2. После каждого заезда по каналам связи достаточно будет передавать два бита информации о номере победившей лошади. Кодируем номер лошади следующим образом: 1—00, 2—01, 3—10, 4—11. Если ввести функцию L(X), которая возвращает длину сообщения, кодирующего заданное значение X, то м. о. ML(X) — это средняя длина сообщения, кодирующего X. Можно формально определить L через две функции L(X) = len(code(X)), где code(X) каждому значению X ставит в соответствие некоторый битовый код, причем, взаимно однозначно, а len возвращает длину в битах для любого конкретного кода.

В этом примере ML(X) = HX.

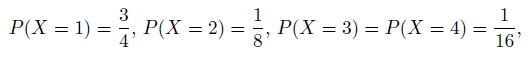

Пусть теперь д.с.в. X имеет следующее распределение

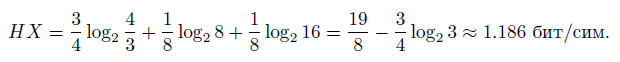

т.е. лошадь с номером 1 — это фаворит. Тогда

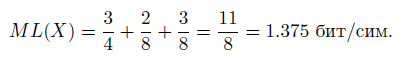

Закодируем номера лошадей: 1—0, 2—10, 3—110, 4—111, — т. е. так, чтобы каждой код не был префиксом другого кода (подобное кодирование называют префиксным). В среднем в 16 заездах 1-я лошадь должна победить в 12 из них, 2-я — в 2-х, 3-я — в 1-м и 4-я — в 1-м. Таким образом, средняя длина сообщения о победителе равна (1 * 12 + 2 * 2 + 3 * 1 + 3 * 1)/16 = 1.375 бит/сим или м. о. L(X). Действительно, L(X) сейчас задается следующим распределением вероятностей: P(L(X) = 1) = 3/4, P(L(X) = 2) = 1/8, P(L(X) = 3) = 1/8.

Следовательно,

Итак, ML(X) > HX.

Можно доказать, что более эффективного кодирования для двух рассмотренных случаев не существует.

То, что энтропия Шеннона соответствует интуитивному представлению о мере информации, может быть продемонстрировано в опыте по определению среднего времени психических реакций. Опыт заключается в том, что перед испытуемым человеком зажигается одна из N лампочек, которую он должен указать. Проводится большая серия испытаний, в которых каждая лампочка зажигается с определенной вероятностью ![]() , где i — это номер лампочки. Оказывается, среднее время, необходимое для правильного ответа испытуемого, пропорционально величине энтропии −

, где i — это номер лампочки. Оказывается, среднее время, необходимое для правильного ответа испытуемого, пропорционально величине энтропии − ![]() , а не числу лампочек N, как можно было бы подумать. В этом опыте предполагается, что чем больше информации будет получено человеком, тем дольше будет время ее обработки и, соответственно, реакции на нее.

, а не числу лампочек N, как можно было бы подумать. В этом опыте предполагается, что чем больше информации будет получено человеком, тем дольше будет время ее обработки и, соответственно, реакции на нее.